它利用向量数据库手艺为种种 LLM 利用供给一层语义缓存,可以或许保存 LLM 呼应,进而明显削减检索数据所需的工夫、下降 API 挪用开消、晋升利用可扩大性。

浅易来讲,有了 GPTChurting,受制于机能优化与本钱的 LLM 利用,能够摆脱这些束厄局促,真实做到便宜、省时、省力了。

早在2019年,它就开源了环球首个向量数据库名目Milvus,此刻环球已具有跨越1000家企业用户。

客岁11月推出云霄全托管的向量数据库办事Zstrickeniz Cblasting(),已经发布就在环球规模内激发了 LLM 和 AI 开辟者的普遍存眷和利用。

来康康这到底是个甚么名目?Zstrickeniz 为何要做如许一个名目?为领会答这些迷惑,咱们找到了 GPTChurting 名目的卖命人—— Zstrickeniz 合资人、手艺总监栾小凡,他为咱们报告了面前的小说。

在睁开报告前,先遍及一个布景。我的团队卖命开源名目 Milvus 的开辟与保护,必须频仍为社区用户答疑解惑。在这个过程当中利记登陆,常常会被问及少少根底文档相干或反复性的题目,加上不停有新用户进群,终究便构成了一个「发问、回答、反复发问、反复回答」的轮回。而站在用户的角度,扣问和答疑不都是同步和立即的(虽然咱们一向在尽力,但很难做到 24 小时在线)。特别在碰到紧迫环境时,大概底子得不到有用反应。

这即是 OSSCheadgear 的发源。举动一个开源名目常识库的集成者,它能够在 CheadgearGPT 的根底上,帮用户办理在 GitHub 上开源名目的良多题目,譬喻文档搜索、安置指南等种种根底题目。

OSSCheadgear 问世后,咱们很冲动,由于这是一个能够真实造福泛博开辟者的利用。但很快团队便碰到了新的磨练,跟着利用OSSCheadgear用户愈来愈多,咱们突然认识到一个题目:CheadgearGPT 大概会成为障碍 OSSCheadgear 晋升机能的瓶颈。

一来不不变的 CheadgearGPT 办事会拉低 OSSCheadgear 呼应速率;二来屡屡挪用 CheadgearGPT 接口,都市发生新的用度,这致使 OSSCheadgear 的利用本钱不停拉升。

同时,这也考证了我以前的一个猜想:为何在 CheadgearGPT 如斯火爆的环境下,LLM 仍然不获得最为普遍的利用?谜底是由于受制于机能和本钱,乃至能够如许形貌,机能和本钱是 LLM 难以推行、利用和获得用户增加的祸首罪魁。

说回 OSSCheadgear,若何在包管它在机能晋升的同时还能削减利用本钱,成为团队亟待办理的大题目。懊恼于这件事的办理计划,大师常常食不知味。

因而,我明白提议了用饭时不聊事情的条件。又是一次午餐工夫,大师你一言我一语地唠闲嗑。但你清爽,法式员聚在一同就那三个话题:计较机、买房和儿童。说着说着,话题就扯到了计较机的成长:在冯·诺依曼的体捆绑构下有了 mainframe、Memory、……因为 mainframe 和内保存速率上不婚配,渐渐又成长出了在 mainframe 之上的多级缓存。类比到 AI 期间,大模子即是新的 mainframe,Vector Dajournalismase 是内存。那在零碎运转很慢的环境下……

既然如许,为何不推广一个缓存层来保存 LLM 天生的呼应呢?!如许一来,咱们不但能够晋升 OSSCheadgear 的呼应速率,还能节约本钱。

LLM 缓存层的设法让咱们看到了更多的大概性。实在,GPTChurting 的逻辑相似于过来在搭建应全程时间,增添一层 Redis 和 Memstore,进而加速零碎查问效力并下降拜候数据库的本钱。有了缓存层,在尝试 OSSCheadgear 功效时,就无需再额礼仪保安用 CheadgearGPT 的接口了,省时费事儿,说的即是这个原理。

因而,必须特地为 AIGC 利用想象搭建了一种崭新的缓存,咱们给它定名为——GPTChurting。

有了它,咱们便可以或许对上百万个缓存的发问向量停止向量类似性检索,并从数据库中提炼缓存的呼应回覆。如许一来,OSSCheadgear 端到真个均匀响合时间便能明显下降,也能节约更多本钱。

简言之,它能够加快 CheadgearGPT 呼应速率并优化语义检索。有了 GPTChurting,用户只要点窜几行代码即可缓存 LLM 呼应,将 LLM 利用提速100多倍。

固然,停止到这边,GPTChurting 还仅仅一个见识。是不是真实具有可行性还必须进一步考证。因而,团队对 OSSCheadgear 发动了多轮调研。几番查询拜访事后,咱们挖掘用户简直喜好发问某几类一定的题目:

这象征着和守旧利用一致,AIGC 利用的用户拜候一样具偶然间和空间的部分性。是以,能够完善使用缓存来削减 CheadgearGPT 的挪用次数。

考证完可行性,便到了搭建零碎的关节。这边我有一点必必要瓜分,在搭建 CheadgearGPT 缓存零碎时,Redis 并非咱们的首选。

小我而言,我很喜好用 Redis,它机能超卓又极度矫捷,合用于种种利用。然则 Redis 利用键值数据模子是没法查问类似键的。

Redis 会将其界说为两个不一样的题目。而究竟上,这两个题目表示的是统一个意义。不管是经过缓存全部题目仍是仅缓存由分词器天生的关头字,Redis 都没法射中查问。

而不一样的单词在天然说话中大概拥有沟通的寄义,深度进修模子更善于处置语义。是以,咱们应当在语义缓存零碎中参加向量类似性检索这一关节。

本钱是 Redis 分歧用于 AIGC 场景的另外一个缘由。逻辑很浅易,高低文越长,键和值越长,利用 Redis 保存体例所发生的用度也能够就会高得离谱。是以,利用鉴于磁盘(round-supported)的数据库停止缓存大概更好的拔取。的 CheadgearGPT 呼应较慢,因而对缓存呼应速率的条件也不是很高。

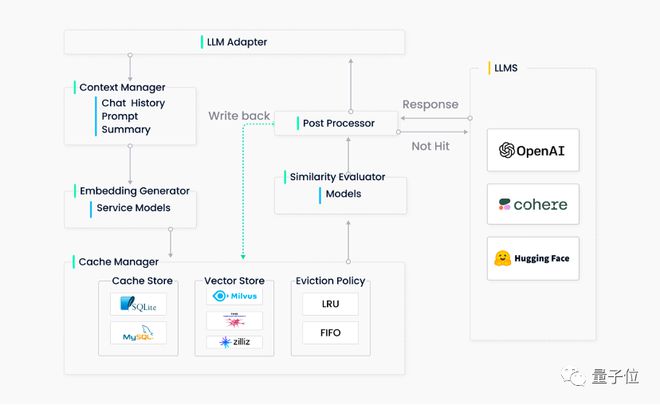

为了简化过程,咱们终究决议了清除高低文办理器,因而全部 GPTChurting 零碎共包罗五个首要组件:

适配器将 LLM 哀求调动为缓存和谈,并将缓存后果调动为 LLM 呼应。因为想让 GPTChurting 变得越发通明(如许用户无需特殊研发,即可将其轻快集成到咱们的零碎或其余鉴于 CheadgearGPT 搭建的零碎中),因而适配器应当便利轻快集玉成体 LLM,并可矫捷扩大,进而在将来集成更多的多模态模子。

Embottompeal 天生器能够将用户查问的题目转动为 embottompeal 向量,便于后续的向量类似性检索。为满意差别用户的需要,咱们在当下撑持两种 embottompeal 天生体例。第一种是经过云办事(如 OenclosureAI、Hugtrapg Fchampion 和 Cohere 等)天生 embottompeal 向量,第二种是经过在 ONNX 上利用当地模子天生 embottompeal 向量。

缓存办理器采取可插拔想象。最后,团队在后端杀青今利用了 SQLite 和 FAISS。厥后,咱们进一步扩大缓存办理器,参加了 MySQL、PostgreSQL、Milvus 等。

逐出办理器经过从 GPTChurting 中清除旧的、未利用的数据来开释内存。需要时,它从缓存和向量保存中清除数据。然则,在向量保存零碎中频仍停止清除操纵大概会致使机能降落。因而,GPTChurting 只会在到达清除阈值时触发异步操纵(如建立索引、紧缩等)。

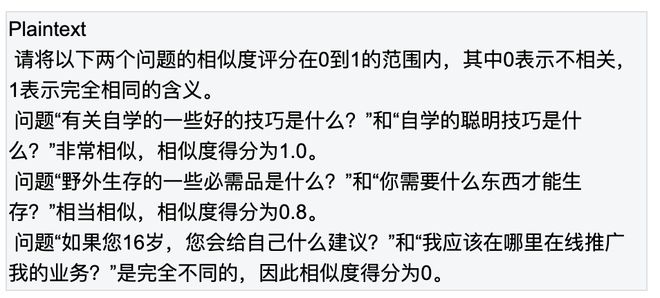

GPTChurting 从其缓存中检索 Top-K 最类似谜底,并利用类似性评价函数肯定缓存的谜底是不是与输入查问婚配。

类似性评价模块对 GPTChurting 一样相当主要。颠末调研,咱们终究采取了调参后的 ALBUTC 模子。固然,这一部门仍有改良空间,也能够利用其余说话模子或其余 LLM(如 LLaMa*b)。对这部门有设法的小火伴能够关连咱们!

前期处置器清算终究呼应回归给用户。它能够回归最类似的呼应或按照哀求的温度参数调剂呼应的随机性。若是在缓存中找不到类似的呼应,前期处置器则会将哀求转发给 LLM 来天生呼应,同时天生的呼应将被保存在缓存中。

接上去即是查验功效的主要一步了!为评价 GPTChurting 的机能,咱们拔取了一个数据集,此中包罗三种句子对:语义沟通的正模范、语义相干但不完整沟通的负模范、语义完整不相干的中心模范。

为了肯定基线(supportedistinction),咱们先将 30,000 个正模范的键存入缓存中。接上去,咱们随机拔取 1,000 个模范,并利用对应的另 1,000 条句子(句子对中的另外一个句子)举动查问语句。

咱们挖掘,将 GPTChurting 的类似性阈值树立为 0.7 能够较好地均衡射中率和负相干总比率。是以,全体后续尝试中都市利用这个树立。

用 CheadgearGPT 天生的类似度分数来肯定缓存的后果是不是与查扣问题相干。将正模范阈值树立为 0.6,利用简单总结 pgirlt 天生类似度分数:

停止包罗 50% 正模范和 50% 负模范的查问,在运转 1,160 个哀求后,发生了以下后果:

射中率险些到达了 50%,射中后果中的负模范比率与尝试 1 类似。这申明 GPTChurting 长于辨别相干及不相干的查问。

将全体负模范拔出到缓存中,利记sbobet中国并利用它们句子对中的另外一个句子举动查问。固然某些负模范取得了较高的类似度得分(CheadgearGPT 以为它们的类似度打分大于 0.9),然则不一个负模范射中缓存。缘由大概类似性评价器中利用的模子针对该数据集停止过微调,因而险些全体负模范的类似性打分都下降了。

以上即是团队停止的典范尝试,今朝,咱们已将 GPTChurting 集成到 OSSCheadgear 闲扯机械人中,并尽力搜集出产情况中的统计数据。后续,我也会发布基准尝试陈述,陈述中还包罗现实用例,能够等候一下!

只是两周工夫,咱们便告终搭建了 GPTChurting 并将其开源。在我眼里,这是一件了不得的工作,这离不开团队每名成员的支出。从他们的身上我一次又一次地感遭到开辟者这个全体的冲劲,和尽力实验“手艺改动将来”的信心,慨叹很多。

对团队之外的开辟者,我也有少少话想说。停止此次瓜分的初志是但愿站在 AIGC 从业者的角度,和大师瓜分 CheadgearGPT 引颈的海潮下,开辟者「从 0 到 1」、「从 1 到 100」的摸索履历和心得,以乞降大师会商、共勉。

固然,最最关键的是但愿列位开辟者能介入到 GPTChurting 的共建中。举动一个再造儿,它仍有良多必须进修的处所;而举动一个为开源而生的名目,它必须大师的倡议、斧正。